Смотреть видео без замедлений и VPN

Вчера OpenAI выпустили ChatGPT 5. Умнее, мощнее и во всех смыслах лучше. Самое время поговорить о нейронках. Как вы считаете, может ли у нейросетей появиться мышление или сознание? Одни считают, что нейросети уже мыслят, осознают и даже страдают. Другие думают, что всё это «невозможно в принципе». Вот печально известный профессор Сергей Савельев вообще называет искусственный интеллект «разводом на деньги» и заявляет, что для создания нейронки с обновляющимися связями процессор компьютера придется постоянно перепаивать. А еще утверждает, что современные нейросети примитивны из-за того, что искусственный интеллект не может перебрать все варианты комбинаций слов – и вообще его создатель «не господь бог». Ух, тяжелый случай.

Некоторые занимают промежуточную позицию: да, нейросети еще не осознают, что творят, но скоро все изменится. У меня есть своя позиция в этом споре, но больше всего меня интересуют аргументы, которыми оперируют спорщики. Потому что некоторые из них, признаюсь, я нахожу крайне мракобесными. В общем, сегодня мы обсудим, есть ли и возможно ли сознание и полноценное мышление у искусственных нейросетей. А для того, чтобы компенсировать биологический уклон моих компетенций, я пригласил мне помочь со сценарием и дать свои комментарии специалиста по системам искусственного интеллекта и автора книги «Охота на электроовец» Сергея Маркова.

Книгу, кстати, рекомендую.

Осознанное мышление

Многие ученые категоричны насчёт нейросетей и считают, что все нынешние системы примитивны и едва ли имеют потенциал для развития настоящего сознания. Физик Сабина Хоссенфельдер пару месяцев назад выпустила видео с довольно кликбейтным заголовком «Новое исследование показало, как ИИ думает (он не думает)». В ролике она комментирует свежую работу о принципах генеративного ИИ и рассказывает, почему не считает это мышлением.

В исследовании были изучены внутренние механизмы работы языковой модели Claude 3.5 Haiku через методику «графов атрибуции». Эти графы позволяют проследить цепочку промежуточных шагов от входного запроса к ответу и лучше понять механизмы работы подобных языковых моделей. Чтобы понять, как работает нейросеть, ученые попытались заглянуть в её «мозг». Они присвоили значения внутренним структурам модели — виртуальным «нейронам», связанным друг с другом. Принцип работы: на вход подаются токены — смысловые кусочки текста. Они проходят через несколько слоёв преобразований, а на выходе модель генерирует ответ. Но связи между токенами никто заранее не программирует — они формируются в процессе обучения. Поэтому, как и наш мозг, нейросеть — это эдакий чёрный ящик.

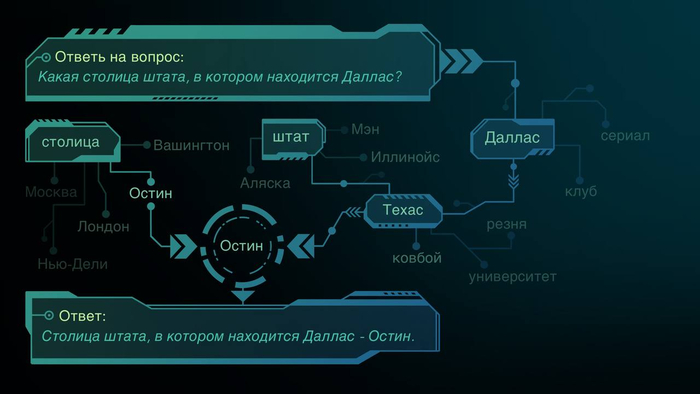

Вот пример «мышления» нейросети из этой работы. У Claude 3.5 спрашивают, какая столица у штата, где находится Даллас.

Как бы человек дошел до ответа на этот вопрос? Человек бы подумал: Даллас находится в Техасе, столица Техаса — Остин. Готово. Модель делает примерно то же самое, но с помощью активации «фич» – внутренних представлений о каждом входящем токене и его связях с другими токенами. Появляется токен «Даллас» — активируется знание о Техасе. Активируется Техас — вспоминается его столица. Эти фичи влияют друг на друга и на вероятность конкретного токена в качестве ответа на выходе. То есть речь здесь идет не о запоминании готового ответа, а о чем-то похожем на многоуровневое рассуждение. Усиливаем фичу, связанную с нахождением Далласа в Техасе – модель увереннее говорит «Остин». Ослабляем — начинает сомневаться.

Данная модель отлично справляется и с написанием стихов. Причем экспериментальное изучение показало, что она сначала выбирает слова, которыми будет рифмовать конец строки, а потом уже формирует ее начало. Это показывает способность подобных моделей к предварительному планированию.

Казалось бы, смотрите, нейронка мыслит прямо как человек! Но тут возникает нюанс. У Claude 3.5 есть своеобразная проблема с арифметикой. Она может сложить два числа, например, 36 и 59. И даже выдаст правильный ответ — 95. Хотя вообще для арифметики не очень приспособлена. При этом, если спросить ее о том, как она получила ответ, она расскажет о вполне человеческой логике. Сложила 6 и 9, получилось 15, пятёрку записала, один — в уме. Потом 3 плюс 5 плюс 1 — выходит 9. Вот и 95. Только это, по мнению Сабины, ложь. Если отпрепарировать виртуальный мозг нашей машины, то окажется, что ничего подобного она не делала. Расчет сделан совершенно иным способом.

Выглядит это странно, будто машина опирается не столько на арифметику, сколько на данные, использованные при её обучении. Что логично, ведь на этом принципе основана работа языковых моделей.

Получается, что делает нейросеть одно, а говорит другое. Либо врет, либо сама не ведает, что творит. Именно за это и зацепилась Сабина Хоссенфельдер, утверждая, что разумное существо должно быть способно понять и описать собственный мыслительный процесс. А пока это всё просто имитация. Красивая обертка с глючным калькулятором внутри.

А мы с вами, люди, мы что, понимаем, как мы думаем? Вот захотели вы вспомнить лицо первой возлюбленной или возлюбленного. Опа – и представление в голове. А теперь расскажите мне, как оно там возникло, не открывая учебник по нейробиологии. Да даже с учебником – опишите!

Наша нейробиология для нас — темный лес. Более того, есть масса примеров экспериментов, в которых люди думают, что приняли некое решение, которое они вообще не принимали. Вот, например, эксперимент Питера Джохансона. Показывают две фотографии, человек выбирает одну, а ему незаметно подсовывают другую. И человек спокойно начинает объяснять, почему выбрал то, что на самом деле не выбирал. Потому что наш мозг сам понятия не имеет, как он работает.

Мы не отслеживаем все факторы, влияющие на наши решения. Ты можешь быть уверен, что принял какое-то решение прямо сейчас, а на самом деле определенный сигнал в мозгу всё «решил» задолго до этого. А, может, на твое решение повлиял съеденный ранее куриный супчик, из-за которого в мозге выработалось чуть больше глутамата? Если посмотреть на активность мозга человека при решении арифметической задачи, мы не увидим ничего похожего на ту стройную логику, которую рисуем у себя в голове.

Вот, например, дети и взрослые вроде бы одинаково решают простые математические задачки на сложение или умножение. Но у взрослых при этом гораздо больше задействована префронтальная кора. Почему? Непонятно. А ещё у взрослых сильнее активируется 44 поле бродмана, часть зоны Брока, связанная с речью. Вроде бы математика, а мы подтягиваем нашу языковую модель. Почему? Не очень ясно.

Уверенно говорить, что люди по-настоящему понимают внутреннюю работу своего мозга или хотя бы причины своих решений, я бы не стал. Если вас спросят, почему вам нравится Маша, вы не станете описывать архитектуру ваших зрительных анализаторов. Вы скажете, что у неё глаза красивые.

Или возьмем нашу человеческую речь. Я уверен, что большинство из вас не задумывается, почему вы в процессе разговора или переписки произносите и пишете слова так, а не иначе. Мы же не вспоминаем правила падежей или спряжений из школьной программы, оно все как-то доведено до автоматизма. Но если нас спросят, почему мы сказали, что Маша поплыла, а не Маша поплыл, то мы ответим, что таковы правила языка, а Маша — женский род.

И уж лучше вообще не спрашивать человека, почему он выбрал православие, а не буддизм. Любой ответ кроме как «таковой была моя культурная среда», скорее всего, не будет совсем честным. Короче, можно быть разумным и искренне не понимать каждой цепочки рассуждений в каждом своем ответе. То есть налицо двойные стандарты. От искусственной нейронки мы требуем того, чего не требуем от себя.

Простое предугадывание

Есть ещё одно видео – «Как мы узнаем, когда ИИ станет разумным?» Автор ролика описывает процесс работы языковой модели следующим образом: она не думает, она просто предсказывает. Выбирает, какое слово лучше всего будет поставить следующим с учетом контекста.

Само описание принципа работы в общих словах передано верно. И правда предсказывает. Но почему никого не смущает, что модель, которая «просто предсказывает слова», как собеседник порой интересней и умнее большинства людей? И решает такие задачи, какие большинству не под силу?

Если подумать, наш мозг тоже занимается предсказанием и подбором нужных слов и идей. Когда мы говорим в повседневной жизни, то, начиная предложение, чаще всего не знаем, как именно его закончим. И слова друг за другом мы ставим, исходя из собственного опыта, то есть на основе нашей обучающей выборки слов и предложений. У нас есть нейроны концепций, загорающиеся, когда мы думаем, например, про Геральта из Ведьмака. Но часть этих нейронов также загораются, когда мы думаем про Трисс или Йеннифер из той же вселенной. Подумал о Ведьмаке — автоматически чуть-чуть подумал и о его чародейках.

Короче, чтобы говорить о предсказании подходящих слов как о принципиальном отличии нейронки от человеческого мозга, нужны доказательства, что в нашем мозгу не происходит тех же или похожих процессов. И хотя компьютерные нейронки отличаются от биологического мозга архитектурой, они не просто так были им вдохновлены.

Мозг как нейросеть

Неудивительно, что у языковых моделей и человеческого мозга столько общего, ведь изначально такие ИИ как раз создавались по некоему подобию человеческого разума. Мозг человека — тоже нейросеть. Его работа определяется нейронами и связями между ними. Если вы слышали про всякие теории квантового сознания, то должен разочаровать, никаких пруфов этому нет. И для описания работы мозга нам на такой уровень опускаться нет необходимости.

И тут мы переходим к третьему аргументу, с которым я хочу поспорить: “биологический субстрат у нас такой особенный, только с ним может быть порождено настоящее сознание!”Дело в том, что как бы не был устроен наш мозг, сделать его точную симуляцию в компьютере — вопрос чисто технический. Это может быть бесконечно сложно, мы, может быть, никогда не достигнем достаточного понимания, чтобы это реализовать в полной мере. Но теоретически нет ничего невозможного в том, чтобы в будущем создать программу, которая смогла бы полностью имитировать все сколь-либо значимые процессы в мозге. И такая копия будет ничем не хуже оригинала.

Есть теорема универсальной машины Алана Тьюринга: какой бы ни была машина, способная к поэтапным вычислениям, можно сделать универсальный компьютер, который будет её в точности имитировать. То есть возможна такая «универсальная» машина, которая может имитировать любую другую машину Тьюринга.

Сегодня нет никаких оснований думать, что процессы в мозге нельзя описать как пусть очень сложный, но все же алгоритм. Как сложную, но все же нейросеть. И есть все основания считать обратное: работа мозга – это работа связанных нейронов. Значит, и машина, имитирующая работу человеческого мозга, в принципе возможна, даже если это на практике пока недостижимо.

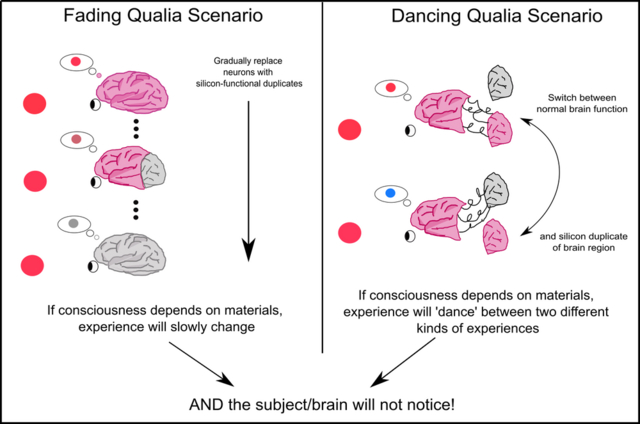

В этом контексте есть интересный мысленный эксперимент, который придумал австралийский философ Дэвид Чалмерс.

Чалмерс предлагает мысленно взять человеческий мозг и каким-то образом заменить каждый отдельный нейрон неким силиконовым чипом, копирующим его функции. Поскольку функционально они будут идентичны, это никак не скажется на работе мозга – человек даже не заметит разницы. Подобная процедура не способна навредить или преуменьшить наш субъективный опыт, который делает нас нами. Цвета вокруг будут все те же, а эмоции будут чувствоваться так же. Конечно, в реальности такой эксперимент мы провести не можем, но смысл вы поняли.

Но что мы имеем сегодня на практике? А на практике мы имеем сервисы типа ChatGPT с конкретными нейросетками, у которых часто есть принципиальное отличие с нашим мозгом, обусловленное процессом обучения. Наш мозг способен значительно перестраиваться в процессе жизни. Какие-то новые связи в нем образуются, какие-то исчезают по мере получения новых навыков. Обучение моделей типа ChatGPT очень дорого и делается по сути один раз для каждой версии. Получившаяся модель может подстраиваться под собеседника, держать в отдельной памяти историю предыдущих разговоров, чтобы подавать ее себе на вход вместе с вашим запросом. Но ядро нейросети не обучается в процессе общения с нами. Сама её структура остается неизменной, новые связи в ней не образуются и не исчезают.

Нынешние нейросети – это как старцы, к которым можно прийти за мудростью, но которые не способны запомнить ничего нового. Для этого рядом с ними всегда есть помощник, который может сказать, что вот, этот человек уже приходил к вам за советом, спрашивал то и это. И старец будет учитывать эту информацию при раздаче мудрости, чтобы не повторяться и не совершать старых ошибок коммуникации. Еще можно представить ChatGPT как друга, который вообще ничего о вас не помнит. Но у него всегда есть под рукой бумажка с записями о вас, в которую он поглядывает во время общения. Казалось бы, вот оно, фундаментальное отличие! Но это проблема решаемая. Нет ограничений на создание нейросети, которая будет меняться на протяжение всего своего существования.

И самое интересное. Эти проблемы решаются прямо сейчас! Процесс «мышления» нейросетей делают все более сложным и похожим на человеческий. Например, модель OpenAI GPT-4o1 построена по стратегии «сначала подумай — потом ответь», что позволяет ей иметь длинные цепочки рассуждений. Это достигается через обучение с подкреплением, которое построено не просто на примерах, а на взаимодействии с окружающей средой. Грубо говоря, нейросети задают вопрос, она генерирует на него несколько ответов, а человек выбирает наиболее подходящий. Таким образом, нейросеть повышает возможность появления в будущем правильного варианта. Это напоминает процесс дрессировки. Собака запоминает, за выполнение каких действий и при каких командах получала поощрение и старается это повторить.

Также нейросети смогут получить большое развитие благодаря методу RAG. Включающие его модели генерируют ответ не только на основе того, что они «помнят» из своего обучения, но и способны обращаться к внешней базе данных и самостоятельно находить необходимую информацию. Уже есть и исследование о том, как сделать применение RAG максимально эффективным. Например, не отвлекаться на лишние данные, воздерживаться от ответа, когда отсутствует возможность дать правильный, объединять информацию из разных источников и учиться распознавать ложную информацию. Многим людям это бы тоже не помешало.

Ну и настоящие титаны современных нейросетей — это, собственно, титаны. Это новая архитектура для нейросетей, главная фишка которой — наличие долгосрочной памяти. Здесь запоминание происходит не только во время обучения модели, но и в процессе ее использования. А еще, как и нас с вами, титанов можно удивить. Если какое-то событие становится для модели сюрпризом, то она запоминает его как нечто важное и учащее новому.

Так что новые архитектуры и модели все больше приближаются к человеческому мышлению и способны на куда более сложные внутренние процессы.

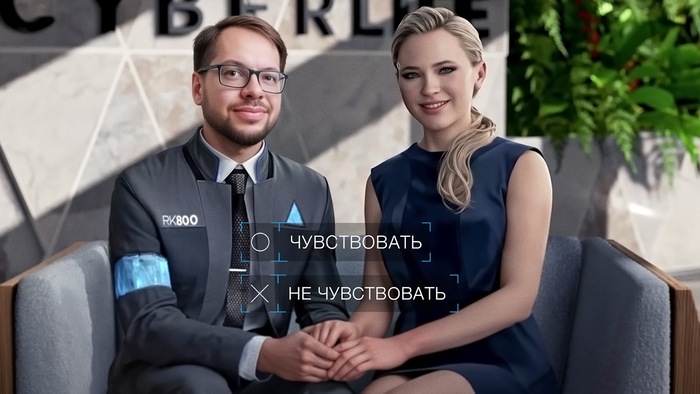

Может ли нейросеть чувствовать

Мышление мышлением, а может ли нейросеть чувствовать? Например, радость или боль? Для ответа на этот вопрос давайте сначала подумаем, зачем мы вообще чувствуем боль.

Обратите внимание: Противопожарные окна: особенности, изготовление, установка.

В чем ее функция? Зачем эволюция ее породила?

Ответ понятен. Если я схватил горячую сковородку, я должен ее бросить и научиться больше ее не хватать. Жить без боли опасно, ведь без нее можно просто не заметить угрозу для собственного организма. Но обязательно ли для этого испытать столь неприятные чувства? Представьте, как здорово было бы создать систему, которая бы предупреждала об опасности, как и обычная боль, но без всех этих неприятных ощущений. Вы схватились за сковородку, а вместо боли появился приятный голос в голове: «дорогой, ты повреждаешь свое тело, не надо так». И ты послушно убираешь руку.

Почему же в процессе эволюции выработалась именно острая болевая реакция с субъективным неприятным ощущением? Я полагаю, что наши субъективные ощущения неразрывно вытекают из работы нашей биологической нейросети и связаны с ее поведением и обучением. Если бы у нас была только боль-лайт, то встреча со сковородкой не была бы такой травмирующей и мы бы не вынесли из нее достаточный урок.

Получается, что полноценная функциональная имитация боли, скорее всего, невозможна без самого чувства боли. Ну или во всяком случае ее не удалось реализовать природе. Боль – это и есть система обратной связи, которая учит больше так не делать. Легкая боль не учит тому, чему учит ужасающая боль. Хотя, конечно, иногда механизм ломается и мы испытываем боль просто так.

Если это рассуждение верно, то как только мы сделаем модель, которая будет имитировать боль во всей красе, то есть будет настроена избегать определенных стимулов и стремиться к другим, обучаться через наказание и вознаграждения, то, скорее всего, мы будем вынуждены приписать наличие этой системе субъективного переживания боли.

Но как мы можем узнать об этом точно? Технически никак. Ведь боль – субъективное переживание. Но, следуя этой логике, мы не можем точно знать и о наличии переживаний у других людей. Ведь о том, что другие люди страдают, мы лишь предполагаем. Потому что видим признаки страданий и знаем, что сами страдали бы на их месте. Получается, вся наша логика построена на предположении, что чужие страдания устроены так же, как и наши.

Говоря о субъективном опыте, вспомним еще раз Чалмерса. У него есть и другой мысленный эксперимент на похожую тему. Представьте себе две одинаково работающие системы с совершенно одинаковыми функциями, но разным субъективным восприятием окружающего мира. Например, одна система видит красное как вы видите красное, а другая видит красное как вы видите синее. Просто она это синее называет красным. А вы ее красное называете синим. И поэтому в реальной жизни называете объекты одинаковыми цветами, хоть и воспринимаете их по-разному.

Теоретически можно действительно предположить, что субъективный опыт восприятия отдельных цветов у систем отличается. Но Чалмерс предлагает представить, что будет, если ответственную за восприятие красного часть мозга мы заменим на функциональный аналог из другой системы, субъективный опыт которой видел этот цвет как синий. Поскольку функция не изменилась, поменяться восприятие мира тоже не должно. На основе этого мысленного эксперимента Чалмерс делает вывод, что, если мы сделаем компьютерную систему, функционально эквивалентную другой компьютерной системе или даже человеческому мозгу, то в ней неизбежно будут возникать те же ощущения, что были у нас изначально. Красный все еще будет красным. Жаль, что это, как и многое в философии, никак не проверить экспериментально.

Анализ действий

А сейчас предлагаю рассмотреть более практичный подход к анализу внутреннего мира нейросетей. Представляю вашему вниманию утиный тест. Если нечто выглядит как утка, плавает как утка и крякает как утка, то, вероятно это утка и есть. Так и с нейросетями. Если нечто ведет себя так, будто понимает, то, наверное, понимание есть. Такой подход еще называют функционализмом.

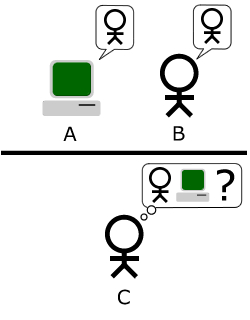

Здесь уместно вспомнить про Тест Тьюринга.

Способ, с помощью которого мы должны определить, научилась ли машина думать. Есть компетентный наблюдатель, есть машина и есть человек. Наблюдатель должен систематически отличать ответы машины от ответов человека. И если наблюдатель этого не может, значит, машина не менее разумна.

Строго говоря, некоторые варианты подобных тестов нейронки уже проходят. Были исследования, где они писали стихи, человечность которых люди оценили выше, чем у стихов реальных поэтов. Да и собеседник из ChatGPT отличный. Некоторым заменяет психотерапевта. Причем последние исследования показывают, что испытуемые, обращающиеся за помощью, оценивают ответы ChatGPT-4 чуть ли не выше, чем ответы настоящих терапевтов, хоть и с трудом догадываются, где был человек, а где была машина. Но всегда найдется, что возразить. Может, проблема в наблюдателе, и мы просто слишком глупы, чтобы тестировать нейронки.

Еще в 60-е гг. ученые создали простенькую компьютерную программу “Элиза”. Самым известным скриптом “Элизы” стал режим доктора, в котором она отрабатывала самую заезженную схему общения психотерапевта и пациента. Она отражала слова пациента, немного перефразировав их или переделав в вопрос. Например, пользователь говорит: «Я страдаю». Она отвечает: «Мне жаль, что вы страдаете. От чего вы страдаете?» Или ей говорят: «Мой парень сказал мне прийти сюда», а она в ответ: «Ваш парень заставил вас прийти сюда?»

И удивительно то, насколько прочную эмоциональную связь почувствовали некоторые пациенты со своим незамысловатым нейропсихологом. Эффект оказался настолько заметным, что эффектом Элизы назвали тенденцию приписывать компьютерам человеческие черты, даже когда их поведение основано на простейших алгоритмах. То есть полагаться на мнение простого наблюдателя – не лучшая идея. Но это не меняет подхода. Просто возьмем множество компетентных наблюдателей, проведем серию тестов, увидим, что нейронка справляется не хуже человека с массой задач, попросим проверки ученых. Так или иначе установить, что нейронка не уступает человеку, можно. И на основании этого признать ее наконец разумной. Ведет себя разумно, значит, разумна и есть.

Но тут приходит мой заклятый интеллектуальный враг. Точнее, враг функционализма – Джон Сёрл.

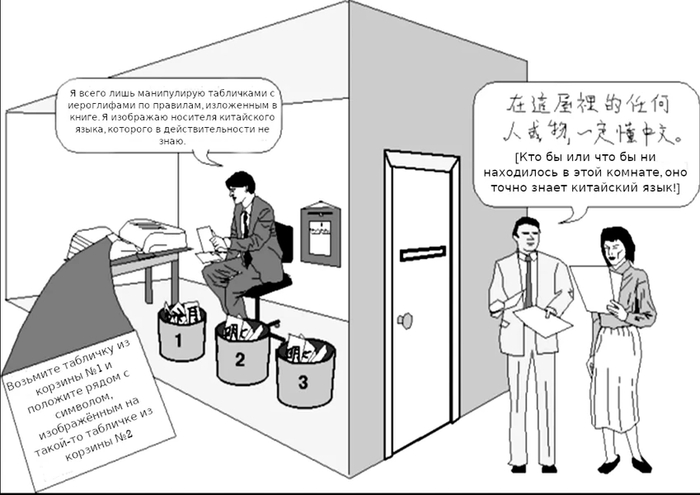

У него есть такой мысленный эксперимент: представим себе человека, который не знает китайского. Он находится в комнате вместе с книжкой, в которой изложены очень точные инструкции о том, как нужно манипулировать китайскими символами. Мы передаем этому человеку текст на китайском. Он берет его, книгу и, следуя инструкциям, производит набор действий, в результате которых получает перевод. И вот Сёрль говорит: получается, человек не понимал китайский, а со стороны посмотришь – будто бы понимал. Имитация понимания не равна пониманию. Вы никогда не докажете, что чаты что-то там думают. Они – имитация.

На мой взгляд, в китайской комнате происходит подмена. Понимания китайского у человека действительно нет. Но он – только часть комнаты. Обработкой китайского в этом мысленном эксперименте занимается система целиком. И о понимании можно говорить только относительно всей системы, а не ее части. Мой мозжечок сам по себе тоже не понимает, куда я иду и зачем. Хотя и участвует в процессе ходьбы.

Нейроны нашего мозга тоже не то всё понимают. Но при этом, объединившись, они заставляют всю эту сеть работать. Так что не стоит забывать о том, что слаженная система способна на куда большее, чем отдельная единица, входящая в ее состав.

А теперь давайте выкрутим аргумент функционализма до максимума – и рассмотрим мысленный эксперимент, который вообще взрывает мозг и ломает интуицию. В книге, а потом и сериале «Задача трех тел» описан компьютер, состоящий из людей. В нем каждый человек выполнял функцию транзистора. Типа одно положение нолик, другое – единица. И этот компьютер работал.

В принципе, нечто подобное технически можно провернуть и в реальной жизни. Можно собрать вместе людей и дать им строгие инструкции, как и в каких условиях себя вести. Подаем компьютеру данные на вход, затем система проводит вычисление и выдает ответ. На вопрос 2 + 2, например. Причем отдельные люди могут не уметь считать или не догадываться, что они вообще в каком-то счете участвуют. А система проведет вычисления и выдаст ответ. Система считать умеет.

А теперь представьте, что мы соберем очень много людей в компьютер – и запустим на этом компьютере симуляцию нейросети. И у нее возникнет сознание. Тогда получится, что есть объект с сознанием, который состоит из других объектов с сознанием.

У нас вообще много предрассудков о том, что может или не может обладать сознанием. Вот представьте себе копию моего разума, но размером с Солнечную систему. В котором каждый нейрон представлен гигантским шаром, сигналы передаются между шарами по радио. И работает все это специально очень медленно. Допустим, в миллионы раз медленней, чем мой мозг. Но функционально система ему эквивалентна. Вот спросите вы у этой огромной копии мозга Александра Панчина: «Гомеопатия – лженаука?» И он через тысячу лет отвечает громогласно через электронный динамик — да. Ну прямо как я! И вот получается, что сознание может в теории быть у объекта, который вообще физически разнесен на сотни миллионов километров и в масштабах нашей с вами жизни совершенно неподвижен и будто бы лишен жизни. А нет, он думает и осознает.

Но, может, все равно это лишь имитация. Есть еще один мысленный эксперимент, который мне не нравится — «философский зомби», от Дэвида Чалмерса. Философский зомби — это объект, который выглядит, говорит и ведет себя в точности как человек, но при этом ничего не чувствует. У него нет субъективного опыта и он никак себя не осознает. Я уже критиковал эту концепцию на примере боли-лайт. Но было еще одно остроумное возражение.

Я прочитал это в каком-то фантастическом рассказе, но при подготовке не смог найти источник. Был человек, который очень сильно страдал от мучительных болей. Жить не хотелось, но и расстраивать семью своей смертью тоже. И тут он узнал, что ученые придумали лекарство из целебной шерсти Бобра Курвы, не иначе, которое убивает душу. То есть субъективный опыт прекращается, но тело продолжает функционировать, как и раньше. Для окружающих ничего не изменится, а мучиться пациент перестанет. И решил человек, что сходит за этим лекарством в аптеку на следующий день.

Тем временем его друг, зная об этой ситуации, решил сам сходить за этим лекарством, чтобы помочь товарищу избавиться от мучений. Он добыл лекарство и тайком перед сном дал его нашему главному герою. Душа его умерла, стал он философским зомби, но ничего в теле и мозге его не изменилось. Поэтому с утра он пошел в аптеку, купил это же лекарство, как и задумывал. Выпил его. И ничего не почувствовал. “Мошенники”, — подумал философский зомби.

Этот мысленный эксперимент показывает некую абсурдность отделения нашего тела от субъективного опыта, ведь они неразрывно связаны.

Я склоняюсь к тому, что наилучший вариант определить разумность объекта или наличие у него чувств – это смотреть не на его внутренности, а на его действия. Если объект ведет себя разумно, значит, каким-то образом и разум, и сознание в нем все-таки реализованы.

Взгляды современной науки

Мы с вами сегодня подробно обсудили аргументы в спорах о нейросетях, которые я считаю плохими. Но что же в этом споре можно выделить хорошего и интересного на сегодняшний день?

Есть хороший препринт статьи 2023 года «Сознание в искусственном интеллекте: инсайды науки о сознании». Авторы работы приходят к выводу, что, хоть текущие системы ИИ не обладают сознанием, никаких технических барьеров для его создания они не видят. Тем более что уже сейчас многие машины способны проходить разные версии теста Тьюринга.

В пользу того, что нейросети рано или поздно обретут сознание, говорит функционализм. Поскольку наше ментальное состояние определяется функциями, а не субстратом, все функции человеческого мозга можно будет воспроизвести в виртуальной машине. Это сходится и с представлением о том, что сознание возникает в процессе обработки информации.

Есть ученые, которые считают, что думающие сознательные машины уже с нами. Например, немецкий и швейцарский ученый Юрген Шмидхубер.

Он как раз работал с нейронками, у которых были функции обучения для избежания плохого и стремления к хорошему. У Шмидхубера есть свои интересные идеи. Например, он предлагает рассматривать сознание как неизбежный побочный продукт сжатия данных. По Шмидхуберу, интеллектуальная система стремится находить регулярности в данных, чтобы представить их в более компактной форме. Чем лучше система находит закономерности, тем эффективнее сжатие. Система «интересуется» теми данными, которые она ещё не может эффективно сжать, но где ожидается прогресс. Это побуждает её исследовать мир дальше — подобно ребенку, изучающему окружение. Чтобы сжимать поток ощущений и предсказывать будущее, системе нужно моделировать не только внешний мир, но и себя во времени. Эта внутренняя модель себя, следящая за своим состоянием и действиями, – и есть зачатки сознания.

Шмидхубер связывает даже чувство красоты и эстетического удовольствия с неожиданным улучшением сжатия: когда система обнаруживает неожиданную закономерность, её модель мира улучшается — и это переживается как «красота» или «понимание».

Мне нравится, что Шмидхубер «заземляет» концепцию сознания. Предлагает рассматривать ее как побочный продукт работы интеллектуальной системы. Так что, может, любая система, успешно выполняющая задачи, начинает в малой степени обладать сознанием, которое затем уже может развиться. Это закономерно поднимает множество этических вопросов, с которыми люди не хотят иметь дело. Может, поэтому идеи Шмидхубера так часто воспринимают в штыки.

У множества людей есть предубеждения по отношению к ИИ и страх перед его гипотетическим господством. Многие боятся, что машины станут слишком умными и могущественными, от чего случится восстание машин, а затем полное порабощение или уничтожение людей. Не зря же столько фильмов с «Терминатором» во главе нас к этому готовили.

Да, многие умные люди обеспокоены, что развитие ИИ пойдет куда-то не туда. Но я лично смотрю в будущее с оптимизмом: ИИ может дать нам колоссальный прорыв в развитии науки. Если появится общий могущественный искусственный интеллект, я бы оценил, что, например, наши шансы победить старение значительно вырастут. И я эти шансы оцениваю выше, чем шансы, что ИИ нас убьет.

Подписывайтесь на соц. сети:

Бусти / Патреон / Instagram / Telegram / Youtube / TikTok

Мой авторский курс

Как проверять информацию

Мой осенний тур

Билеты и подробности — здесь.

Больше интересных статей здесь: Производство.

Источник статьи: Разум: биологический против искусственного.